Aplicação

Soluções para sistemas de aprendizado de máquina

Soluções de conectividade de alta velocidade e energia para sistemas de aprendizado de máquina e inferência.

Nosso mundo está mais conectado do que nunca com bilhões de dispositivos IoT na borda coletivamente gerando uma tremenda quantidade de dados. Insights sobre esses dados mudam a maneira como fazemos negócios, interagimos com as pessoas e vivemos nossas vidas diárias. A geração desses insights ocorre processando os dados através de redes neurais para reconhecer padrões e categorizar as informações. Uma vez treinada a rede neural, o modelo pode ser implantado para processar e analisar novos dados. Isso é comumente conhecido como inferência. Reconhecimento de fala, detecção de objetos, classificação de imagens e personalização de conteúdo e mecanismos de recomendação são aplicações cotidianas que podem tirar proveito da inferência.

Os usuários finais exigem insights em tempo real nessas aplicações, levando a inferência a ocorrer em dispositivos móveis e no limite. Os diferentes tipos de acelerador de hardware, como FPGAs, GPUs e ASICs, são usados para classificar e caracterizar os dados. Cada um desses dispositivos difere no processamento de potência e consumo de energia, com cada um tendo benefícios dependendo da carga de trabalho. Alguns desses dispositivos são aproveitados tanto para treinamento quanto para inferência, enquanto alguns são dedicados a qualquer um deles.

- As FPGAs (Field Programmable Gate Arrays – Matrizes de portas programáveis em campo) são comumente usadas para acelerar os processos de rede e armazenamento e para descarregar essas tarefas da CPU.

- As GPUs (Graphics Processing Units, Unidades de processamento gráficas) foram projetadas para lidar com tarefas simultâneas e podem processar grandes conjuntos de dados de forma mais eficiente do que as CPUs.

- Circuitos integrados específicos da aplicação, ou ASICs, são processadores projetados em torno de cargas de trabalho ou tarefas específicas para permitir a eficiência energética ideal.

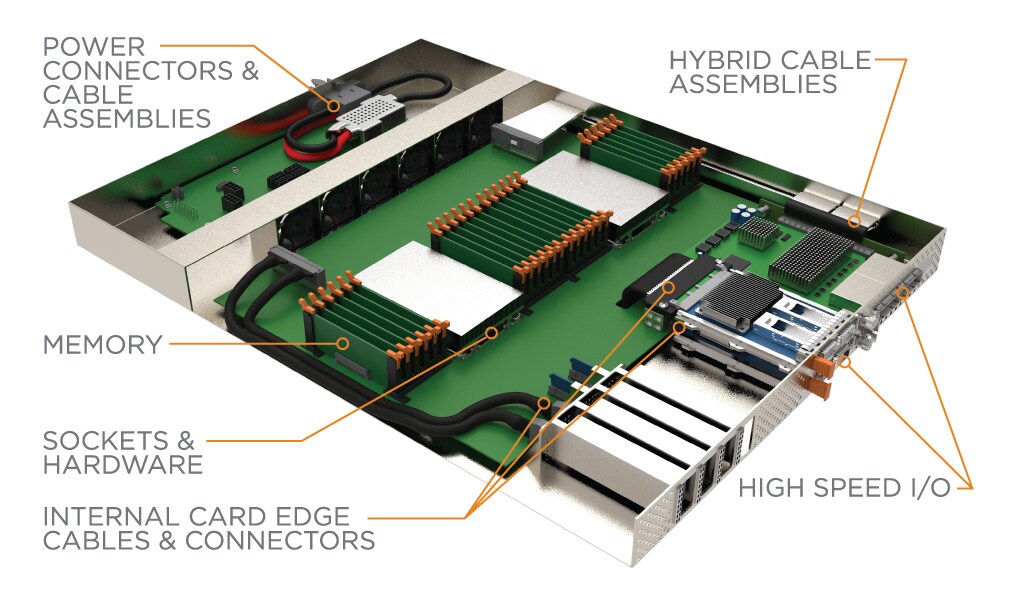

Os aceleradores de hardware são frequentemente conectados a outros dispositivos de computação e armazenamento, agrupados em grandes tecidos e conectados à rede maior. As conexões de rede podem aproveitar protocolos como Ethernet e InfiniBand, que normalmente usam fatores de forma de E/S de alta velocidade, como OSFP e QSFP-DD. O PCIe é aproveitado para conectar dispositivos de armazenamento, placas de interface de rede (NICs) e aceleradores de hardware à CPU. A família de conectores e cabos Sliver da TE é compatível com a especificação SFF-TA-1002 e permite que esses dispositivos se conectem e operem nas velocidades PCIe Gen 5 e Gen 6.

O Compute Express Link (CXL) e o Gen-Z estão surgindo e rapidamente adotaram protocolos que visam remover o gargalo de memória, permitindo a memória coerente do cache. Isso ajuda a impulsionar novas arquiteturas, criando a necessidade de tecidos PCIe externos que usam produtos de conectividade como CDFP e Mini-SAS HD.

O conector de backplane e o sistema de cabos STRADA Whisper de alta velocidade da TE podem permitir a modularidade do sistema oferecendo uma conexão de acoplamento cego a velocidades PAM-4 de 112 Gbps.

e

e

e

e

e

e