A = el anfitrión C = Chris Blackburn

Le damos la bienvenida a Connected World, un podcast para que los ingenieros obtengan más información sobre tendencias que influyen en el mundo conectado y tecnologías que convierten lo que hoy es imposible en lo increíble del mañana.

A: Hola, bienvenidos a CONNECTED World, un podcast de TE Connectivity. Soy su anfitrión de hoy, Tyler Kern. Hemos escuchado mucho sobre las nuevas tecnologías, como la inteligencia artificial. Pero, ¿qué es exactamente la IA? ¿Cómo repercute en nuestras vidas actualmente? ¿Qué permitirá hacer en el futuro? Hoy, nos acompaña en el podcast, Chris Blackburn. Es tecnólogo en el equipo de Arquitectura de sistemas de TE Connectivity. Chris, muchas gracias por acompañarme.

C: Sí, gracias, Tyler, gracias por recibirme.

A: Es un placer. Chris, comencemos por lo básico. ¿Cómo definirías la inteligencia artificial y de qué se trata?

C: La IA está en todas partes en el mundo. Creo que la mayoría de nosotros estamos familiarizados con las cosas de la casa, por ejemplo la asistencia por voz, como Alexa y Siri. Y, por supuesto, cuando nos unimos a las redes sociales, recibimos constantemente contenido depurado. Nos muestran productos en los que hemos hecho clic o hemos visto en el pasado. Así que la IA está absolutamente integrada en esos reinos. En realidad, es una forma de que las máquinas aprendan por sí mismas y generen datos por sí mismas y así, aprendan nuestros comportamientos y nos proporcionen los datos que queremos. De nuevo, hay tantas aplicaciones diferentes aquí, un montón de cosas geniales que suceden en el espacio.

A: Mencionaste este tipo de dispositivos domésticos inteligentes. No podría cocinar sin la pantalla de inicio de Google que tenemos en nuestra cocina, ¿verdad? Tienes razón, hay IA en todas partes. Ese es un excelente punto. Tengo una pregunta que se divide en dos partes. ¿Cuáles han sido algunos de los principales usos de la IA? ¿Y cuáles son las nuevas aplicaciones que estás viendo en el espacio?

C: Algunos de esos casos de uso principales se encuentran en el ámbito del marketing, y nuevamente se aseguran de que los productos que nos interesan lleguen a los consumidores. Entonces, si compro un determinado producto en Amazon, Amazon se aprende mi historial de compras y puede sugerir productos en el futuro. Por ejemplo, podrías ver que otros clientes lo compraron, porque compraste ciertos productos. Entones, creo que en este aspecto, los motores de recomendaciones son realmente uno de los principales casos de uso. Sin embargo, uno de los cambios que vemos aquí y de los aspectos interesantes, es lo que yo llamo entornos remotos y hostiles, incluso algunas aplicaciones que requieren una privacidad extrema de los datos. Este es el caso de la exploración de petróleo y gas, la minería y la extracción de recursos naturales, y aquello realmente importante como la agricultura, la producción de alimentos, el acceso al agua y el control de aguas residuales.

A: Eso es muy interesante. He escuchado algo sobre la IA en el pasado y siento curiosidad por saber si la información es correcta, digamos. En el pasado, escuché a la gente decir que la IA es tan buena como los datos de los que se alimenta. ¿Es cierto? ¿Puedes explicar cómo se construye la IA y cómo funciona?

C: Sí, por supuesto. Cuando alimentamos datos a una red neuronal. A eso lo llamamos aprendizaje automático o entrenamiento, y eso definitivamente así, los datos son en realidad lo que debemos usar para entrenar esos modelos. Si tienes un conjunto de datos pequeño o un conjunto de datos deficiente, los modelos no van a ser tan buenos. Pero lo interesante es que entrenamos ese modelo, y luego lo implementamos en los casos de uso reales. Es lo que llamamos inferencia. Ahora que tengo este modelo entrenado, le agrego nuevos datos y deduce a partir de ellos, eso es lo que se espera. Lo más interesante de la IA es que el ciclo no es unidireccional. Es un ciclo repetitivo. A medida que la IA infiere a partir de los nuevos datos, estoy constantemente construyendo y compilando mi conjunto de datos. Entonces, cuanto más usamos funciones como esta, más cosas le pregunto a Alexa y más inteligente se vuelve. Esto es realmente aprendizaje automático en esencia.

A: Eso es muy interesante. Entonces, a medida que obtienes un tipo de muestra más amplio y más grande y se recogen más datos, se vuelve más inteligente y hace, quizás, mejores recomendaciones o llega a mejores conclusiones basadas en el hecho de que le estás brindando más datos y es capaz de tomarlos y tomar decisiones más inteligentes.

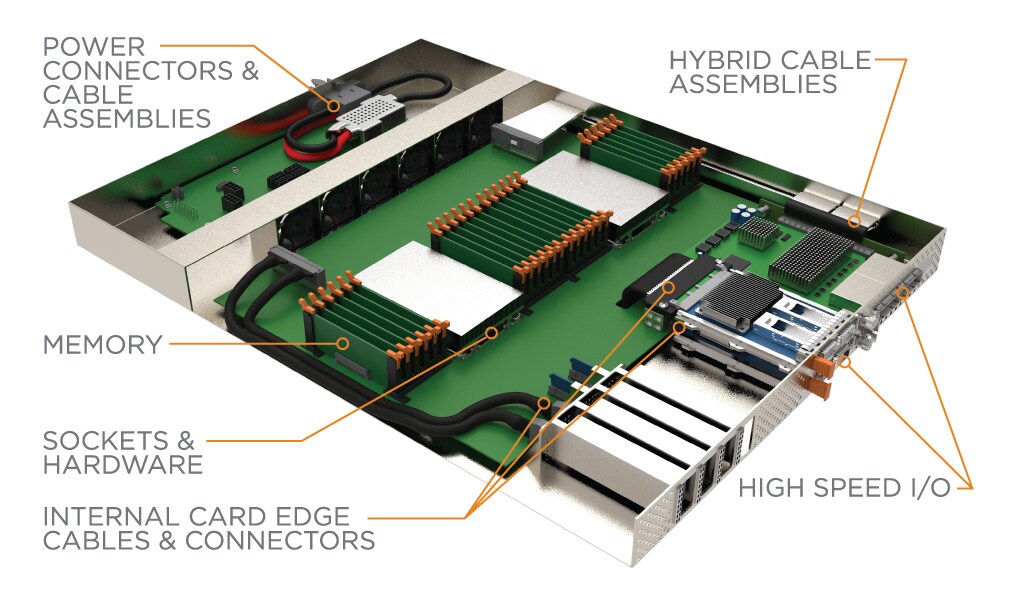

C: Absolutamente. Esto es grandioso. Obtenemos modelos más precisos, pero también se presentan desafíos: dónde y cómo voy a almacenar esta cantidad masiva de datos, cómo voy a transferirlos desde los centros de datos de borde y los centros de datos en la nube tradicionales. Solo esta enorme cantidad de datos que se están generando. En el pasado, nos remontamos a unos 10, 15 años atrás, muchos de los datos que se generaban en el mundo eran datos generados por humanos a partir de las entradas de nuestros teclados o grabaciones, películas, cosas así. Ahora estamos entrando en esta era de datos generados por máquinas. Es solo una explosión absoluta de datos, que ciertamente influye en cómo estamos construyendo arquitecturas de sistemas y manejando esto ahora.

A: Por supuesto. Así que cuéntame algo sobre los esfuerzos que se están haciendo desde el punto de vista del hardware, porque parece que allí también se están obteniendo desarrollos.

C: Por supuesto. Creo que una de las claves aquí es la migración de la informática, el almacenamiento y estos aceleradores de IA hacia la fuente de los datos. Por lo general, tenemos estos grandes centros de datos. Fijamos esa red y los datos entran y salen de los centros de datos y permanecen en esos centros de datos. Ahora estamos empezando a ver que esos recursos informáticos y recursos de almacenamiento se acercan más a donde la gente y estas máquinas están generando los datos. Y esa es realmente la convergencia de lo que llamamos informática de borde con los dispositivos de Internet de las cosas y puntos finales. El 5G ha sido un factor decisivo en la transmisión de estos datos a través de estas redes recién definidas.

A: Este podcast se llama Connected World, ¿verdad? Hemos escuchado mucho sobre 5G y cómo va a cambiar el mundo, cómo va a permitir el intercambio gratuito de datos, velocidades mucho más rápidas y ese tipo de cosas. ¿Cómo impacta el 5G en el desarrollo de la IA y su crecimiento a una escala más amplia?

C: Hemos hablado sobre este ciclo repetitivo de entrenar estos modelos y luego inferir e implementar estos modelos. Al analizar el 5G, ahora tengo una comunicación muy rápida directamente en la fuente de datos hacia y desde las cosas. Entonces, cosas como la asistencia por voz de la que hemos hablado o todas las aplicaciones en los teléfonos inteligentes, desde búsqueda y redes sociales, y todas estas cosas, vamos a obtener respuestas más rápidas y en tiempo real. La población ya ni siquiera quiere esperar uno o dos segundos para obtener información. Y esa información debe estar disponible a pedido. El 5G permite que esa comunicación sea lo más rápida posible.

A: Entonces, Chris, ¿qué desafíos ves que se presentan para los ingenieros a juzgar por las últimas tendencias en IA y aprendizaje automático? ¿En qué tipo de cosas están trabajando realmente los ingenieros y tal vez deban superar con urgencia para continuar trabajando en el campo de la IA y el aprendizaje automático?

C: Comencemos con la energía. La energía es uno de esos recursos que son finitos. Cuando observamos el tamaño de un centro de datos en la nube, hay tanta energía que puede entrar en ese edificio y consumirse. Así que en este momento estos centros de datos no son tan sostenibles como nos gustaría que fueran. Entonces, existe esta tendencia de centros de datos sostenibles y energía renovable en estos centros de datos. Pero nos fijamos en la IA, en los dispositivos específicos, ya sean GPU o diferentes ASIC, requieren mucha energía y consumen bastante. Así que tenemos esta especie de tope de energía, en la entrega de energía. Desde el punto de vista del chip, asegúrate de que estas GPU y ASIC consuman poca energía. Ese es ciertamente un aspecto en el que la comunidad de ingeniería debe trabajar y es bastante desafiante. Del otro lado se encuentra la escalabilidad. Ya hablamos de todos estos diferentes sitios finales, centros de datos de borde, centros de datos en la nube, ¿cómo ampliamos estos sistemas a escala masiva? Y pensamos en empresas como Microsoft, Amazon, Facebook y Google. A estos los llamamos la hiperescala. Y su infraestructura es increíblemente grande. Cuando paso de la pila mecánica de las placas de circuitos, servidores, cables, conectores, ¿cómo integro todo esto de una manera que tenga sentido? Y simplemente ampliar estos centros de datos y sistemas es un desafío extremo.

A: Definitivamente, definitivamente. ¿Qué desarrollos en la IA te emociona ver particularmente? A medida que todo evoluciona, ¿qué te emociona en estos días?

C: Creo que la atención médica es algo absolutamente increíble, como la telemedicina, los controles periódicos en la población de edad avanzada. Los médicos pueden leer radiografías o buscar diferentes tipos de cáncer solo a través de imágenes, mirando esas imágenes. Eso es lo que es absolutamente una necesidad humana. La IA puede ayudarnos, a la población humana, a vivir más tiempo, a vivir más saludablemente. Mencioné antes parte de la producción de alimentos, el acceso al agua y cosas por el estilo. Pero, por supuesto, también hay un lado divertido de las cosas. Todos tenemos filtros en Instagram o Snapchat. Ese es el resultado directo de la IA. Mira la clasificación de imágenes y cosas como esas. Tengo una historia particularmente divertida aquí. Google tiene un producto llamado Arte y Cultura. Puedes tomarte una foto y subirla. Hay clústeres de TPU que echan un vistazo a esa imagen. La emparejan con una imagen correspondiente de pinturas renacentistas. Esto coincidió con mi cara con una imagen de Simon George de Cornualles, que se dibujó en la década del 1400. Ahora uso esta miniatura en todo mi negocio para ocupar la comunicación como Microsoft Teams, Skype y cosas por el estilo. Definitivamente, hay que divertirse un poco.

A: Eso es increíble. ¿También tienes barba como Simon George de Cornualles?

C: Sí, las mismas barbas, manchadas y el mismo sombrero.

H: Ah, y el mismo sombrero, bueno. Tienes que completar el look, tienes que redondear el concepto, ciertamente. Como estabas diciendo de los grandes jugadores en IA, uno de los nombres que mencionaste, se destacó para mí, por diferenciarse otros, es el caso de BMW. ¿Puede la IA jugar un papel importante cuando se trata de, tal vez vehículos autónomos en el futuro?

C: Hablo de estos grandes conjuntos de datos complejos, sabes tu modelo es tan bueno como los datos que estás poniendo y entrenando. Nvidia está absolutamente arraigada en este automóvil sin conductor y vehículo autónomo. Pero, por supuesto, los fabricantes de automóviles como BMW, Toyota, tanto los vehículos de lujo como los estándar. Creo que lo que estamos viendo es que estas tecnologías de los centros de datos realmente se abren camino en el sector automotor. Cuando miramos qué contiene un automóvil ahora, es una variedad de estos sensores, cámaras y cosas. Cuando miro la cantidad de datos que un vehículo está recopilando, un automóvil sin conductor está recopilando cantidades impresionantes. Recientemente Nvidia presentó algunas cifras que hablan de 400 petabytes de datos sin procesar con 100 vehículos al año. Cuando observamos la seguridad y cómo vemos estos vehículos autónomos, queremos ponerlos frente a todos los escenarios posibles, acelerar en la esquina, poner a un peatón por ahí, ver cómo reacciona este vehículo. Cuantas más situaciones le presentes, mejor podremos entrenar y ajustar estos modelos que son soluciones seguras y confiables para el transporte.

A: Entonces, grafícalo en algunos ejemplos sobre cómo esto va a cambiar nuestras vidas o cambiar el mundo que conocemos Mencionaste la atención sanitaria. Eso es definitivamente importante, la producción de alimentos, cosas en esa línea. Pero, ¿cómo podrían cambiar nuestras vidas verse en diez años debido a un mayor crecimiento en la IA?

C: Mencioné algunos de esos campos clave. Hablamos un poco sobre el transporte. Otro de los cambios podrían ser las finanzas. Entonces, ¿dónde debemos poner nuestro dinero para la jubilación y cómo se deben reajustar las asignaciones? El sector fintech está absolutamente en auge y tratando de tomar estas decisiones en tiempo real, ¿cómo manejar nuestro dinero? Así que realmente, todos los campos se verán afectados por la IA, desde la fabricación hasta el transporte, los productos farmacéuticos. Examinemos la investigación y el descubrimiento de fármacos. Ahora puedo repetir rápidamente muchas combinaciones posibles diferentes y llegar a nuevas soluciones muy rápidamente. Dicen "si debe fallar que falle rápido". Creo que eso es lo que sucede aquí.

A: Mi última pregunta es egoísta, porque la IA puede ayudarme con mi próximo draft de Fantasy Football.

C: Creo que sí. Puede que no sea acertado, pero en función de lo que todos los demás eligieron, o digamos a quién eligió el ganador del año pasado, simplemente copia esas elecciones.

A: Buena idea. Necesito toda la ayuda que pueda obtener en estos días. Tengo que cuidar la reputación entre mis amigos.

C: Por supuesto.

A: Excelente. Chris Blackburn. Es tecnólogo en el equipo de Arquitectura de sistemas en TE Connectivity. Chris, muchas gracias por acompañarme hoy y hablar sobre algunas de las aplicaciones de la IA, hacia dónde va el futuro, por darnos un panorama general de la industria y todo lo que está sucediendo. Gracias por acompañarnos.

C: Me lo pasé genial.

A: Por supuesto. Yo también. Espero que todos ustedes disfruten escuchando este episodio. Por supuesto este podcast se llama Connected World. Es un podcast de TE Connectivity. Si aún no te has suscrito al podcast en Apple o Sportify, asegúrate de suscribirte para mantenerte al día con todo lo que está sucediendo en el mundo conectado con las tecnologías avanzadas. Por supuesto, volveremos pronto con más episodios en el podcast. Hoy fui su anfitrión, Tyler Kern. Gracias por escucharnos.

e

e

e

e

e

e