Anwendung

Lösungen für maschinelles Lernen

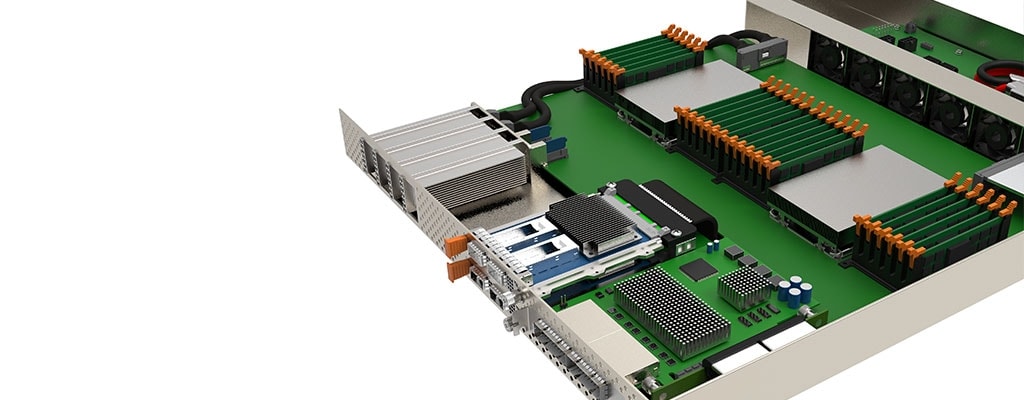

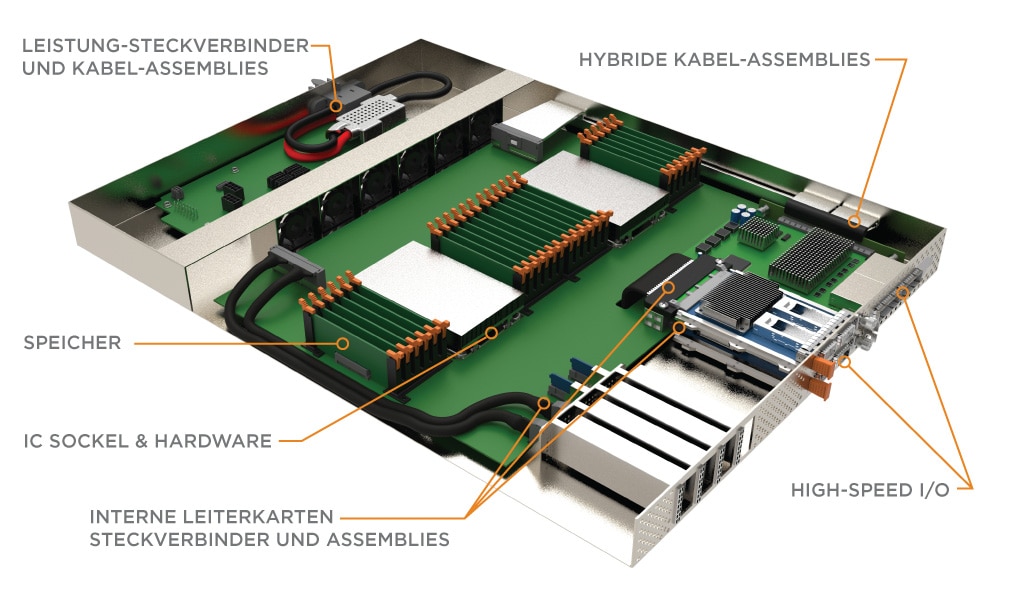

Hochgeschwindigkeits- und Stromversorgungslösungen für maschinelles Lernen und Schlussfolgerungsmaschinen

Mit Milliarden von IoT-Geräten im Edge, die eine enorme Datenmenge generieren, ist unsere Welt vernetzter denn je. Erkenntnisse aus diesen Daten verändern unsere Geschäftsabläufe, unsere Interaktion mit unseren Mitmenschen und unsere tägliche Lebensweise. Wir gewinnen diese Erkenntnisse durch die Verarbeitung von Daten über neuronale Netzwerke zur Erkennung von Mustern und Kategorisierung von Informationen. Sobald das neuronale Netzwerk entsprechend trainiert ist, kann das Modell bereitgestellt werden, um neue Daten zu verarbeiten und zu analysieren. Dies wird allgemein als Schlussfolgerung bezeichnet. Spracherkennungs-, Objekterkennungs-, Bildklassifizierungs- sowie Inhaltspersonalisierungs- und Empfehlungssysteme sind alltägliche Anwendungen, die von Schlussfolgerungen profitieren können.

Endbenutzer verlangen Echtzeiteinblicke in diese Anwendungen, wodurch Schlussfolgerungen mehr und mehr auf mobilen Geräten und im Edge stattfinden. Die verschiedenen Hardware-Beschleuniger-Typen wie FPGAs, GPUs und ASICs werden verwendet, um die Daten zu klassifizieren und zu charakterisieren. Jedes dieser Geräte unterscheidet sich in Verarbeitungs-PS-Leistung und Stromverbrauch, wobei jedes Gerät je nach Arbeitsbelastung Vorteile bietet. Manche dieser Geräte eignen sich sowohl zum Training als auch für Schlussfolgerungen, während andere nur für einen der Bereiche konzipiert sind.

- Field Programmable Gate Arrays (FPGAs) werden häufig verwendet, um Netzwerk- und Speicherprozesse zu beschleunigen und die CPU von diesen Aufgaben zu befreien.

- Grafikprozessoren (Graphics Processing Units, GPUs) sind für die gleichzeitige Verarbeitung von Aufgaben ausgelegt und können große Datensätze effizienter verarbeiten als CPUs.

- Anwendungsspezifische integrierte Schaltungen (application-specific integrated circuit, ASIC) sind Prozessoren, die auf bestimmte Workloads oder Aufgaben ausgelegt sind, um eine optimale Leistungseffizienz zu ermöglichen.

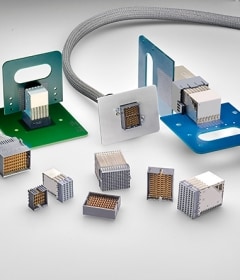

Hardware-Beschleuniger werden häufig mit anderen Compute- und Speichergeräten vernetzt, in großen Strukturen zusammengefasst und mit dem größeren Netzwerk verbunden. Netzwerkverbindungen können Protokolle wie Ethernet und InfiniBand nutzen, die normalerweise Hochgeschwindigkeits-I/O-Formfaktoren wie OSFP und QSFP-DD verwenden. PCIe wird genutzt, um Speichergeräte, Netzwerkschnittstellenkarten (NICs) und Hardware-Beschleuniger mit der CPU zu verbinden. Die Sliver Steckverbinder- und Kabelreihe von TE entspricht der SFF-TA-1002-Spezifikation und ermöglicht diesen Geräten Verbindungen und den Betrieb mit PCIe Gen 5- und Gen 6-Geschwindigkeiten.

Compute Express Link (CXL) und Gen-Z sind neu entstehende, rasch angenommene Protokolle, die darauf abzielen, Speicherengpässe zu beseitigen, indem sie Cache-kohärenten Speicher aktivieren. Dies trägt dazu bei, neue Architekturen zu entwickeln, wodurch externe PCIe-Fabrics benötigt werden, die Konnektivitätsprodukte wie CDFP und Mini-SAS HD verwenden.

Der STRADA Whisper Hochgeschwindigkeits-Backplane Steckverbinder und das Kabelsystem von TE ermöglichen die Modularität des Systems dank einer Blindsteck-Verbindung mit Geschwindigkeiten von 112 Gbit/s PAM-4.

e

e

e

e

e

e